Nationalgeographic.co.id—Pada 2017, sebuah studi kontroversial yang menyatakan kecerdasan buatan (AI) dapat memprediksi orientasi seksual seseorang melalui foto wajah menuai reaksi keras. Kalangan akademisi, pakar teknologi, dan pembela hak LGBTQ mengkritik studi ini. Penelitian ini dilakukan oleh peneliti Universitas Stanford.

Studi ini telah ditinjau oleh ilmuwan lain dan diterima untuk diterbitkan di Journal of Personality and Social Psychology milik American Psychological Association (APA).

Namun, studi ini menuai kecaman setelah pertama kali dilaporkan oleh The Economist pad 9 September 2017. APA sendiri menyatakan sedang "memeriksa lebih dekat" penelitian ini karena "sifatnya yang sensitif," seperti yang dikonfirmasi juru bicara APA kepada NBC News.

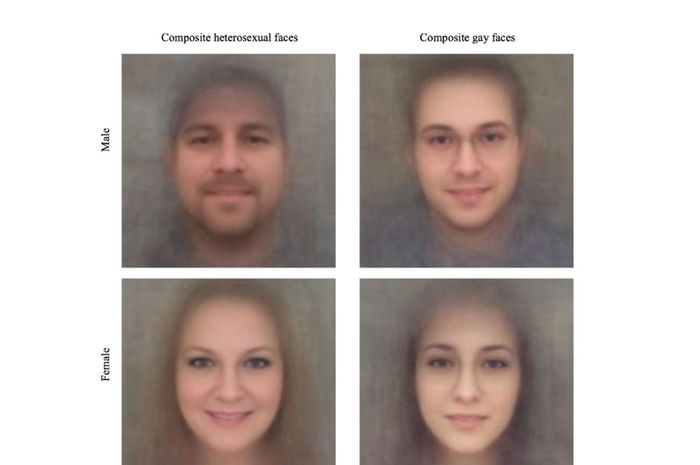

Studi berjudul "Deep neural networks are more accurate than humans at detecting sexual orientation from facial images," melatih model komputer. Tujuan dari studi yang kemudian dikenal sebagai “gaydar” itu adalah mengenali ciri "atipikal gender" pada pria gay dan lesbian.

Peneliti Yilun Wang dan Michal Kosinski menulis dalam abstrak makalah bahwa wajah mengandung lebih banyak informasi tentang orientasi seksual. Informasi ini bahkan tidak dapat dirasakan dan diinterpretasikan oleh otak manusia.

“Dengan satu gambar wajah, pengklasifikasi dapat dengan benar membedakan antara pria gay dan heteroseksual dalam 81% kasus, dan dalam 74% kasus untuk wanita. Hakim manusia mencapai akurasi yang jauh lebih rendah: 61% untuk pria dan 54% untuk wanita,” papar keduanya.

Abstrak tersebut juga menyebutkan bahwa pria dan wanita gay cenderung memiliki morfologi wajah, ekspresi, dan gaya perawatan yang atipikal gender. Hal ini sesuai dengan teori hormon prenatal tentang orientasi seksual.

Kala itu, kelompok advokasi LGBTQ seperti GLAAD dan Human Rights Campaign (HRC) juga mengecam studi ini. Mereka mengeluarkan pernyataan bersama yang mengkritik penelitian tersebut dan potensi penyalahgunaannya.

Kepala Petugas Digital GLAAD, James Heighington, menyatakan teknologi tidak dapat mengidentifikasi orientasi seksual. Teknologi ini hanya mengenali pola pada sebagian kecil orang gay dan lesbian kulit putih yang terbuka di situs kencan yang terlihat serupa. Metode ini adalah cara peneliti mendapatkan gambar untuk penelitian mereka.

Heighington menambahkan, “Pada saat kelompok minoritas menjadi sasaran, temuan sembrono ini dapat berfungsi sebagai senjata untuk merugikan baik heteroseksual yang secara tidak akurat diungkapkan, maupun orang gay dan lesbian yang berada dalam situasi di mana pengungkapan diri berbahaya.”

Jae Bearhat, seorang individu gay dan nonbiner, juga mengungkapkan kekhawatiran pribadi. Teknologi semacam ini dapat berbahaya bagi komunitas LGBTQ. Menurut Bearhat, penelitian ini menghidupkan kembali diskusi tentang "gen gay" dan konsep homoseksualitas sebagai ciri fisik yang dapat diidentifikasi.

Baca Juga: Sains Kontroversial: Perilaku Biseksual Secara Genetik Terkait dengan Kecenderungan Ini

Kerangka kerja biologis yang ketat ini dapat dengan mudah mengarah pada gagasan untuk "menyembuhkan," "mencegah," dan mengidentifikasi homoseksualitas sejak lahir. Hal ini dapat mengembalikan pandangan bahwa homoseksualitas adalah penyimpangan fisiologis atau penyakit mental yang perlu "diobati."

Akademisi Sherry Turkle dari Massachusetts Institute of Technology (MIT) juga memperingatkan. Profesor dan penulis buku "Reclaiming Conversation" ini mempertanyakan siapa yang memiliki teknologi ini dan hasilnya. Turkle khawatir "teknologi" menjadi komoditas. Informasi tentang seksualitas seseorang yang didapatkan dari teknologi ini dapat diperjualbelikan untuk tujuan kontrol sosial.

Turkle berspekulasi teknologi ini dapat digunakan untuk mendiskriminasi LGBTQ dalam pekerjaan. Diskriminasi institusional dapat menjadi lebih efisien.

“Jika ternyata militer tidak menginginkan siapa pun seperti saya, mereka atau organisasi lain mana pun dapat membeli data tersebut," katanya. "Dan bagaimana dengan pengenalan wajah yang dapat mengetahui apakah Anda memiliki keturunan Yahudi? Bagaimana itu akan digunakan? Saya sangat, sangat tidak menyukainya.”

Alex John London, direktur Pusat Etika dan Kebijakan di Carnegie Mellon University, menekankan urgensi perlindungan hak asasi manusia dan undang-undang anti-diskriminasi.

Penelitian Stanford ini menggunakan alat dan teknik yang mudah diakses. Jika temuan penelitian ini akurat, ini menunjukkan betapa mudahnya AI mengungkap informasi pribadi dari data online yang dibagikan secara sukarela.

London menambahkan bahwa sulit untuk mengendalikan penyalahgunaan data besar dan AI. Ancaman sebenarnya bukanlah teknologi itu sendiri, tetapi prasangka, intoleransi, dan sifat buruk manusia.

Michal Kosinski membela penelitiannya di Twitter. Ia menyatakan senang karyanya dan Wang memicu perdebatan. Dalam pernyataan bersama, kedua peneliti ini menganggap kritik terhadap penelitian mereka berasal dari pengacara dan petugas komunikasi yang kurang memiliki pemahaman ilmiah.

"Jika temuan kami salah, kami hanya membunyikan alarm palsu," bunyi pernyataan itu. "Namun, jika hasil kami benar, penolakan spontan perwakilan GLAAD dan HRC terhadap temuan ilmiah membahayakan orang-orang yang diperjuangkan oleh organisasi mereka."

KOMENTAR